Необходимые инструменты

Для глубокого анализа взаимосвязей между токенами в текстах и языковых моделях необходим набор специализированных инструментов. В первую очередь, это библиотеки для обработки естественного языка, такие как spaCy, NLTK и HuggingFace Transformers. Они позволяют проводить лемматизацию, токенизацию и извлечение контекста. Вторым ключевым элементом являются фреймворки машинного обучения, включая PyTorch и TensorFlow, которые обеспечивают гибкость в построении и обучении нейросетей. Кроме того, визуализация данных играет решающую роль: библиотеки вроде Matplotlib, Seaborn и Plotly помогают наглядно представить взаимосвязи между токенами в виде графов, тепловых карт или кластерных диаграмм. Для нестандартного анализа можно использовать графовые базы данных Neo4j или NetworkX для моделирования лексических отношений в виде сетей. Это позволяет выйти за рамки линейных связей и исследовать сложные семантические структуры. Не менее важно иметь доступ к большим корпусам текстов и предобученным языковым моделям, таким как BERT, GPT или RoBERTa, которые уже захватывают сложные паттерны взаимосвязей в своей архитектуре внимания.

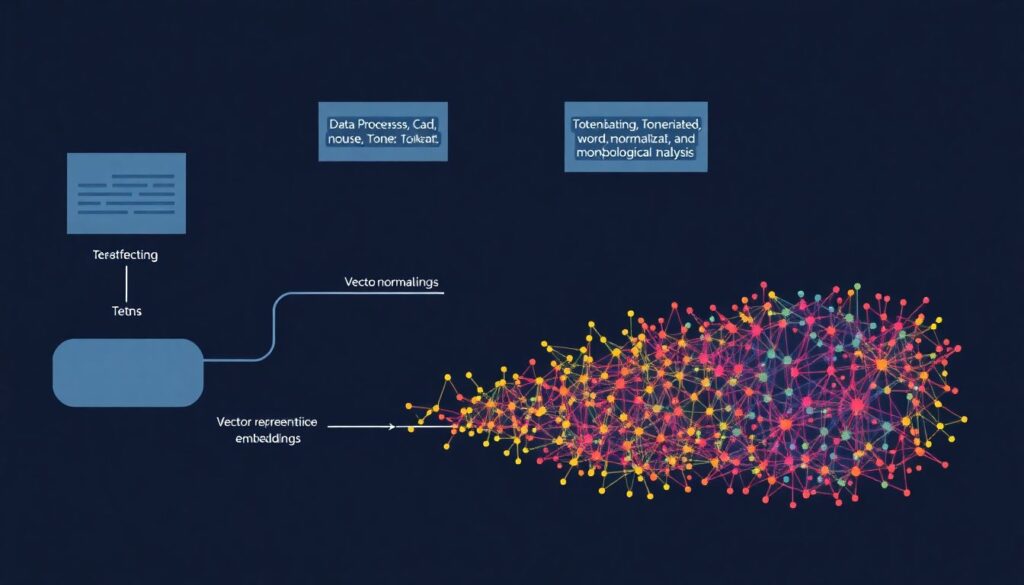

Поэтапный процесс

Анализ взаимосвязей между токенами начинается с предварительной подготовки данных. На этом этапе проводится токенизация, удаление шумов, нормализация словоформ и — при необходимости — морфологический разбор. После очистки данных осуществляется построение векторных представлений: можно использовать word2vec, GloVe или контекстные эмбеддинги из трансформеров. Эти представления позволяют количественно измерять семантическую близость между токенами. Далее начинается фазовый анализ взаимодействий: с помощью механизмов внимания в трансформерах можно отследить, какие токены влияют на другие в процессе генерации текста. Более нестандартный подход — построение графов взаимосвязей, где узлы — это токены, а ребра — весовые коэффициенты их влияния друг на друга. Такой граф можно кластеризовать или анализировать с точки зрения центральности для выявления ключевых узлов. Еще один интересный метод — динамический анализ: отслеживание изменений взаимосвязей между токенами в зависимости от контекста. Например, токен “банк” в контексте финансов и в контексте природы будет иметь разные связи. Это можно моделировать через контекстно-зависимые эмбеддинги или attention-срезы. На последнем этапе проводится визуализация: тепловые карты внимания, t-SNE проекции или force-directed графы помогают интерпретировать результаты и выделить закономерности.

Устранение неполадок

При анализе взаимосвязей между токенами часто возникают трудности, связанные с неоднозначностью контекста, перегрузкой информации или некорректной токенизацией. Первая проблема — потеря точности из-за слишком короткого контекста: если входной отрезок текста слишком мал, модели не удаётся уловить полные зависимости. Решение — увеличение длины контекста или работа с последовательностями через скользящее окно. Вторая проблема — семантический шум: в текстах могут присутствовать редкие или неинформативные токены, которые искажают связи. Здесь помогает частотная фильтрация, либо применение attention-масок, ограничивающих влияние таких токенов. Иногда возникают ошибки в токенизации, особенно при работе с языками, где границы слов не всегда очевидны. В этом случае стоит использовать кастомные токенизаторы или обучать их на специфическом корпусе. Также может наблюдаться «затухание внимания», когда в глубокой трансформерной архитектуре старшие токены перестают оказывать влияние на поздние слои. Для устранения этой проблемы используют упреждающие механизмы, такие как позиционные эмбеддинги с обучаемыми параметрами или архитектурные модификации, например, ALiBi или Rotary Embeddings. Визуализация тоже может вводить в заблуждение: если шкалы цветов не нормированы или граф перегружен, интерпретация становится неточной. В таких случаях необходимо применять методы снижения размерности и выбирать метрики, отражающие только значимые связи.

Нестандартные решения

Помимо стандартных методов, стоит рассмотреть нестандартные подходы к анализу взаимосвязей между токенами. Один из них — использование топологических данных анализа (TDA). Этот метод позволяет рассматривать связи между токенами как многомерные структуры, выявляя устойчивые паттерны в виде гомологий и циклов, которые невозможно увидеть через линейные модели. Другой оригинальный путь — применение квантовых моделей языка, где вероятности токенов интерпретируются как амплитуды, а связи между ними — как интерференционные паттерны. Такие модели позволяют описывать сложные языковые феномены, как, например, полисемию или контекстную зависимость, с точки зрения суперпозиции. Также можно экспериментировать с гибридными графами: совмещать синтаксические деревья с графами внимания, получая многослойную структуру взаимосвязей. Ещё один перспективный подход — использование генеративных моделей, таких как вариационные автоэнкодеры (VAE), для изучения латентных зависимостей между токенами, неявно присутствующих в тексте. Это особенно полезно при работе с художественными текстами или метафорами, где прямые связи выражены неявно. Наконец, анализ взаимосвязей можно перенести в область временных рядов, рассматривая последовательности токенов как сигналы и применяя к ним методы спектрального анализа, выделяя доминирующие частоты, соответствующие устойчивым языковым ритмам и паттернам. Такие подходы позволяют заглянуть в глубинные структуры языка и предложить новые способы его интерпретации.