Why repeatable analyses matter more than “one‑hit” insights

Когда компании говорят, что «мы принимаем решения на основе данных», почти всегда всплывает одна проблема: вчерашние красивые дашборды сегодня уже нельзя повторить. Repeatable analyses — это такие разборы данных, которые можно воспроизвести кнопкой или скриптом, не изобретая велосипед заново. За период 2022–2024 годов рынок business intelligence and analytics services стабильно рос по оценкам аналитиков на устойчивые однозначные проценты в год, и ключевой запрос клиентов звучит одинаково: «покажите, что ваш процесс стабилен». То есть ценится не яркий разовый инсайт, а последовательный трек‑рекорд: серия однотипных, сопоставимых отчетов, по которым видно динамику, а не только разовый всплеск.

Key definitions: repeatability, reproducibility, credibility

Договоримся о терминах, чтобы не путаться. Repeatability — это способность запустить один и тот же анализ на новых данных и получить те же шаги и логику. Reproducibility — когда другой человек, имея исходные данные и код, воссоздает тот же результат. Credible track record — это история анализов, по которым видно: методика стабильна, а выводы со временем подтверждаются действиями и результатами бизнеса. Большинство data analytics consulting services сегодня уже продают не просто отчеты, а именно такую «историю надежности». В итоге репутация аналитика строится не на красивых слайдах, а на том, что его выводы можно повторить и проверить постфактум.

Designing analysis workflows that can be rerun

Чтобы анализ был повторяемым, важен не только SQL или Python, а сама «конструкция» процесса. Нужны четкие входы (источники данных), формализованные трансформации и стандартизованный вывод, который превращается в business data analysis and reporting solutions, а не в разрозненные файлики. За последние годы многие компании перешли от разовых Excel‑отчетов к пайплайнам в облаке именно потому, что разовый скрипт трудно повторить через полгода. Хорошая практика — хранить код и конфигурации в системе контроля версий и документировать, какие параметры можно менять, а какие являются частью стандарта. Это звучит скучно, но именно такие мелочи делают анализы промышленными, а не кустарными.

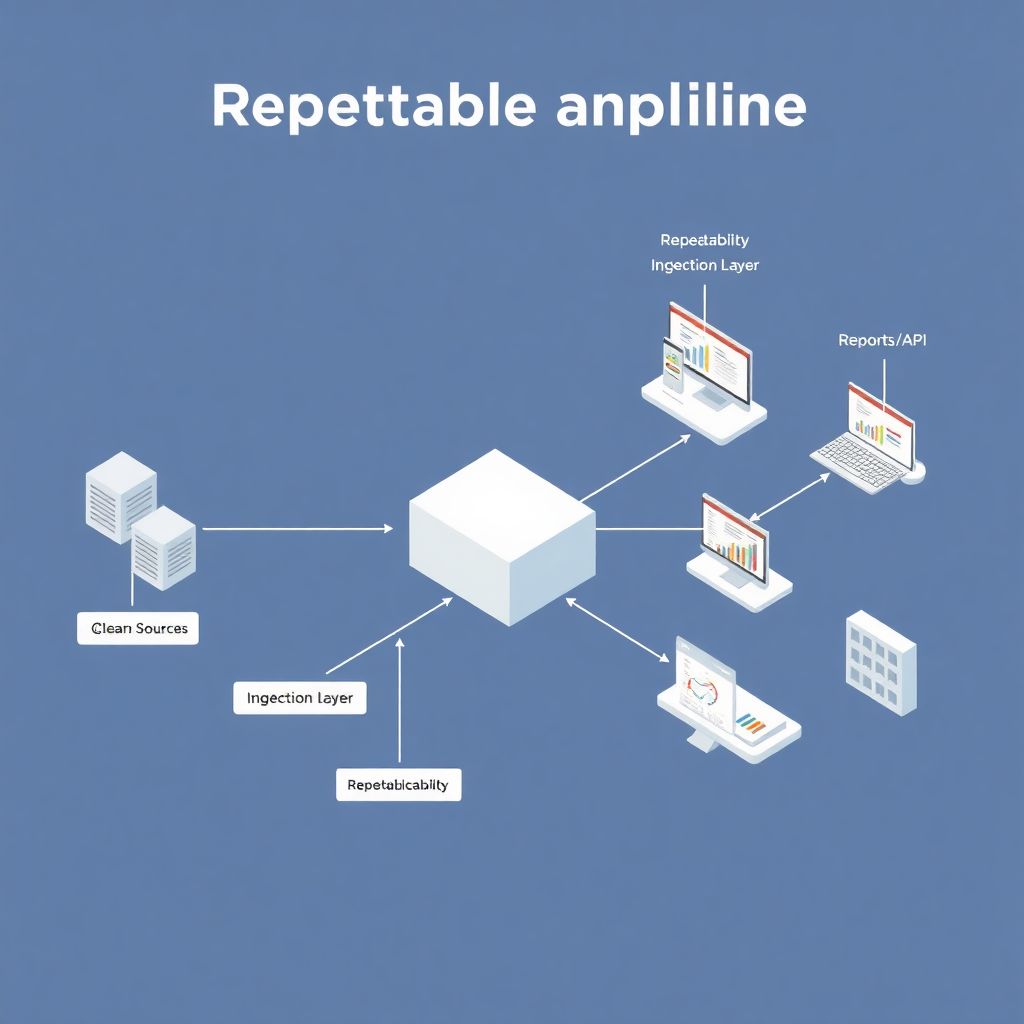

Text-based diagrams of a repeatable analytics pipeline

Представим схему без картинок, только текстом. Базовый repeatable pipeline можно описать так:

[Data Sources] → [Ingestion Layer] → [Clean & Transform] → [Model/Logic] → [Report/API].

Каждый блок — это отдельный набор шагов. Источники: CRM, веб‑аналитика, ERP. Слой загрузки отвечает только за перенос данных, без логики. Очистка и трансформация приводят все к единым справочникам и форматам. Модель — это бизнес‑логика, например, расчет LTV или маржинальности. На выходе рождаются дашборды или API, которые дальше питают business intelligence and analytics services. Если вы можете задокументировать такой «конвейер» и перезапускать его по расписанию, у вас есть основа для воспроизводимого трек‑рекорда.

Comparing ad‑hoc analytics to industrialised analytics

Ad‑hoc аналитика — это когда маркетолог просит: «Скинь, пожалуйста, сколько мы потратили на рекламу в июне», а аналитик вручную собирает данные. Industrialised analytics — когда аналогичный запрос закрывается регулярным отчетом, а любые новые вопросы решаются расширением стандартного конвейера. Практически все крупные компании, которые за 2022–2024 годы увеличивали инвестиции в data-driven decision making consulting, переходили как раз от первой модели ко второй. В первой мир субъективен: каждый новый человек считает по‑своему. Во второй мир ближе к инженерии: есть версии логики, регрессионные тесты для метрик и единый источник правды, что сильно упрощает доказательство надежности аналитических выводов.

Real-world examples and stats from the last three years

За последние три года консультанты отмечают устойчивый сдвиг: клиенты просят не «разовый аудит», а «настроить так, чтобы мы могли это регулярно пересчитывать». Публичные обзоры рынка указывают, что в 2022–2024 годах мировые расходы на инструменты для аналитики и отчетности росли быстрее, чем общий ИТ‑бюджет, что показывает интерес именно к масштабируемым решениям. По опросам профильных исследовательских компаний в 2023 году большинство руководителей заявляли, что ключевая проблема — не нехватка дашбордов, а недоверие к цифрам и несогласованность метрик. Там, где появилась прозрачная, повторяемая методика, быстрее принимались решения об эксперименте и запуске новых продуктов, а проекты по data analytics consulting services легче окупались.

Practical steps to build your own credible track record

Чтобы не утонуть в теории, разложим путь к надежному трек‑рекорду на несколько шагов:

1) Зафиксируйте определения метрик. «Выручка», «активный пользователь», «заказ» — все это должно быть описано текстом.

2) Автоматизируйте хотя бы один ключевой отчет: пусть он обновляется по расписанию, а логика хранится в репозитории.

3) Ведите журнал версий логики: что и когда изменилось, почему, какие эффекты.

4) Показывайте менеджерам динамику одной и той же метрики за долгий период, чтобы они видели устойчивость подхода.

5) Если вы хотите hire data analyst for business insights, спрашивайте не только про любимые инструменты, но и про примеры повторяемых анализов, которые этот человек уже выстраивал.

Where consulting, products and internal teams meet

Повторяемые анализы особенно важны на стыке внешних подрядчиков и внутренних команд. Когда вы привлекаете data analytics consulting services, полезно сразу договориться: код, модели и описание метрик должны оставаться у вас и работать без внешнего участия. То же самое касается data-driven decision making consulting: ценность не в единоразовой красивой презентации, а в том, что через год вы сможете нажать «run» и получить аналогичный отчет уже на новых данных. Зрелые провайдеры business data analysis and reporting solutions помогают встроить свои наработки в вашу инфраструктуру, а не держат вас на «аналитической игле». В итоге выигрывают все: консультанты получают кейсы, а бизнес — проверяемый трек‑рекорд аналитики.