Understanding the problem: what “AI-driven crypto research” really means

Before building an AI crypto research platform, you need to pin down what “research” is in this context. Для одних это фундаментальный анализ on-chain данных и токеномики, для других — поиск альфа-сигналов для трейдинга, для третьих — просто удобный агрегатор метрик. Ошибка большинства команд: они пытаются сделать всё сразу, превращая продукт в перегруженную панель с бесконечными дэшбордами. Гораздо продуктивнее выбрать 2–3 ключевых сценария: поиск новых токенов, анализ риска портфеля, мониторинг новостей и настроений рынка.

—

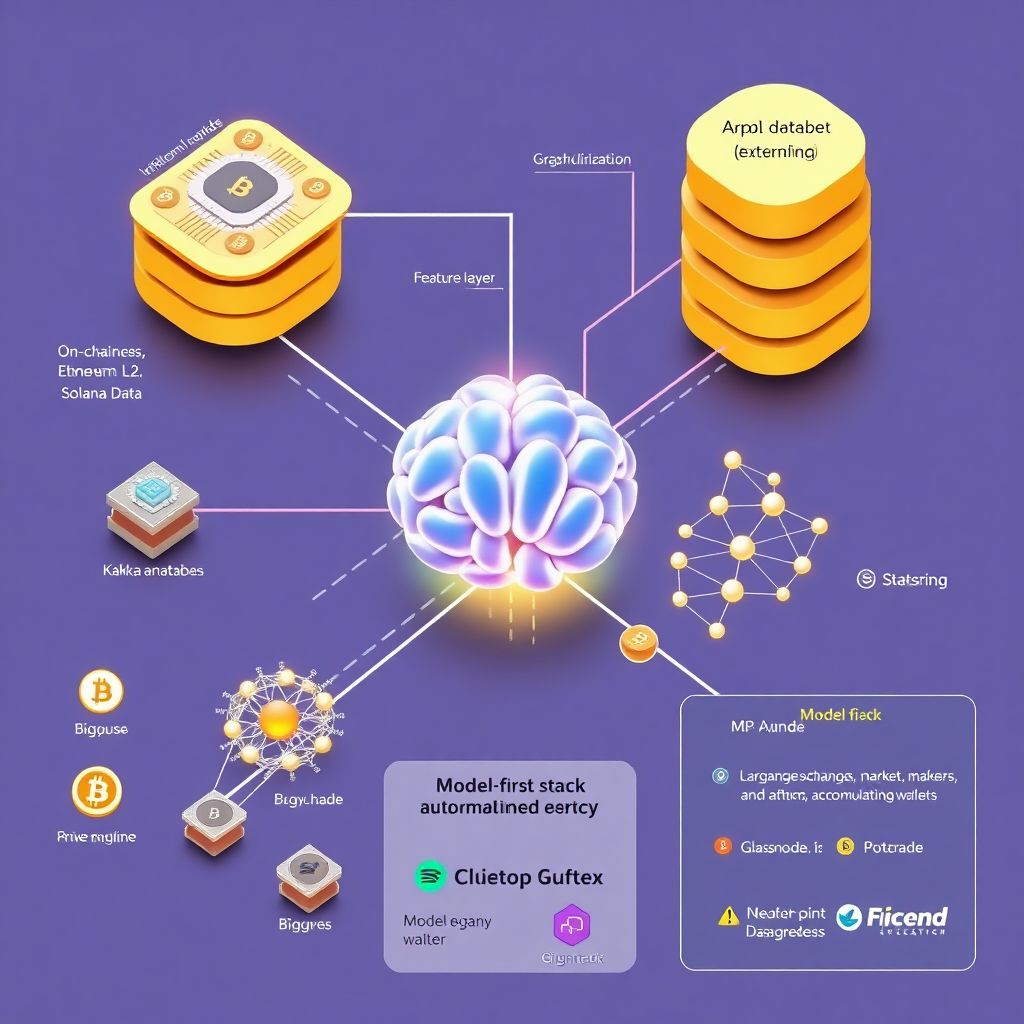

Core architecture: data-first vs model-first подходы

Data-first: сначала хранилище, потом интеллект

Data-first подход предполагает, что вы сначала строите надёжный конвейер данных, а уже затем добавляете ML‑модули. В крипте это особенно критично: любая ошибка в ончейн‑агрегации может искажать метрики на десятки процентов. При таком подходе вы фокусируетесь на ETL: нормализация блокчейн‑данных, привязка цен, дедупликация адресов, затем строите слой фич и только потом — модели для скоринга токенов, кластеризации адресов и т.д. Это снижает риск, но замедляет вывод продукта на рынок.

Technical note — базовый стек для data-first:

– Stream ingestion: Kafka / Redpanda + блокчейн-нод или провайдер (Alchemy, QuickNode)

– Storage: ClickHouse или BigQuery для аналитических запросов, S3/GCS для сырья

– Feature layer: dbt или custom Python-пайплайны с Airflow / Dagster

Model-first: быстрый MVP, потом спасаемся от данных

Model-first подход популярен у стартапов, которые хотят быстро показать демо AI crypto research platform инвесторам. Команда берёт готовые API (Glassnode, CoinMetrics, Nansen, новостные фиды, Twitter/X firehose), прогоняет через готовые LLM‑ы и модели временных рядов, а затем строит воронку обратной доработки данных. Плюс: MVP можно собрать за 4–6 недель. Минус: вы сильно зависите от внешних источников и можете упереться в стоимость и ограничения лицензий, а также в невозможность воспроизвести метрики полностью локально.

—

Choosing the data: on-chain, off-chain и альтернативные источники

On-chain: не только транзакции, но и поведение адресов

Базовый слой — это транзакционные данные из основных сетей (Bitcoin, Ethereum, L2, Solana). Однако для серьёзного анализа одной «сытой» транзакции мало. Важно строить графы адресов, выделяя кластеры бирж, маркет-мейкеров, ботов и розницы. Такой граф можно использовать для идентификации аномалий: например, резкое накопление альткоина «тихими» кошельками до листинга. Для этого обычно строят граф в Neo4j или используют graph-движки поверх PostgreSQL с индексами по адресам и временным меткам.

Off-chain: новости, соцсети и структурированные метрики

Off-chain данные дают контекст: новости, форумы, GitHub‑активность разработчиков, регуляторные апдейты. Многие AI crypto market intelligence platform решения переоценивают соцсети и недооценивают структурированные сигналы: релизы протокола, количество уникальных контрибьюторов, частоту обновлений смарт-контрактов. Комбинация количественных данных (коммиты, pull requests, issues) и тонального анализа новостей позволяет строить более устойчивые индексы «здоровья» проекта, менее подверженные бот-активности и шороху вокруг хайповых тем.

—

Analytics layer: rule-based vs ML vs LLM-подходы

Правила и скрипты: быстро, прозрачно, но плохо масштабируется

Rule-based подход — это набор детерминированных правил и фильтров: «объём торгов вырос > 50 % за 24 часа», «количество активных адресов за неделю удвоилось», «GitHub‑активность выше медианы сектора». Такой слой легко объяснить пользователю и регулятору. Он прекрасно подходит для базового automated crypto research software: вы можете за пару спринтов покрыть 70 % частых запросов. Но когда правил становится сотни, поддержка превращается в ад: коллизии, ложные срабатывания, рост технического долга.

ML-модели: от скоринга токенов до предсказания волатильности

Классический ML в крипте — это регрессия и классификация: вероятность делистинга, вероятность «pump & dump», прогноз краткосрочной волатильности. Типичный пайплайн: вы берёте исторические данные по 500–1500 токенам, извлекаете 50–200 фич (ликвидность, объём, распределение держателей, on-chain прибыль/убыток), делите на train/test, и обучаете модели типа XGBoost или LightGBM. Качество часто измеряется ROC-AUC или Precision@K, где K — топ‑N сигналов, которые реально видит трейдер.

Technical note — пример фич для риск‑скоринга токена:

– Доля топ‑10 адресов в обороте и в владении

– Средний срок удержания токена кошельками

– Соотношение объёма DEX/СEX в последние 7–30 дней

– Интенсивность деплоев смарт-контрактов, связанных с проектом

LLM и генеративные модели: от резюме до диалогов

LLM-подходы хорошо решают задачи интерпретации: объяснить пользователю, что значит всплеск активности, собрать TL;DR по 20 статьям, сгенерировать отчёт по портфелю. Здесь под капотом обычно retrieval-архитектура: вы индексируете новости, твиты, форумы, PDF‑документы исследовательских компаний в векторное хранилище, а затем LLM по запросу пользователя подтягивает нужные фрагменты и строит ответ. Такие решения с превращают «сырые» данные в понятный текст, снижая порог входа для не‑квантов.

—

Встраиваемость в трейдинг: от аналитики к действию

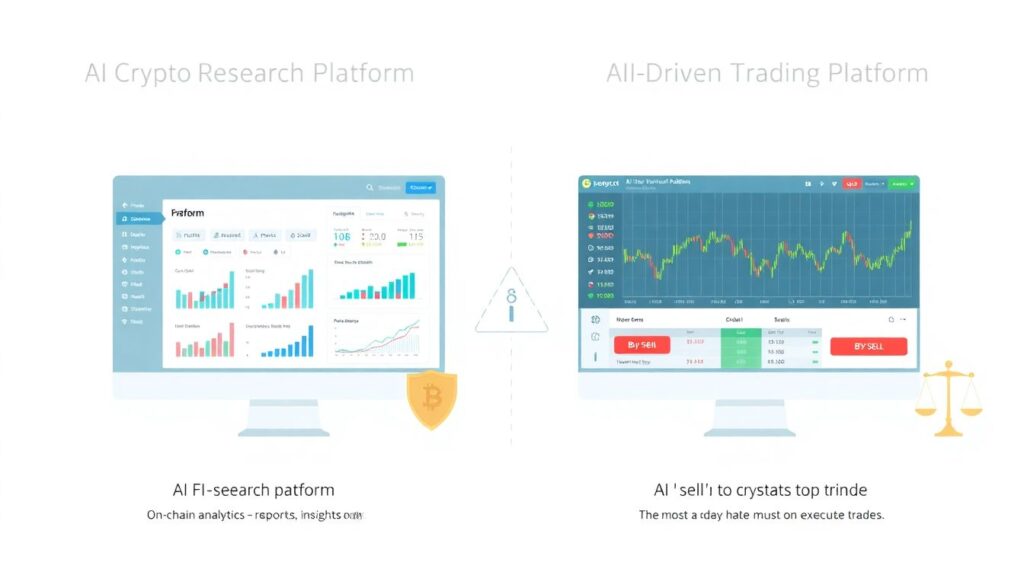

Исследовательская платформа vs AI-driven trading

Важно отделять AI crypto research platform от AI-driven cryptocurrency trading platform. В первом случае цель — дать пользователю качественную информацию и инсайты, во втором — генерировать и исполнять сделки. Смешивать их в одном продукте опасно: возникают вопросы ответственности, лицензирования и конфликт интересов. Зрелые команды обычно строят отдельные модули: аналитика формирует сигнал, а торговый движок (часто в другом юрлице) решает, как его использовать, с учётом лимитов риска и регуляций юрисдикции клиента.

Сигналы vs стратегии: два уровня автоматизации

Сигналы — это «сырой» выход модели: оценка вероятности события, индекс риска, ранжирование токенов. Стратегия — это набор правил, как использовать сигналы: пороги входа/выхода, леверидж, лимиты по активам. Лучшие практики: давать пользователю возможность видеть и тестировать оба слоя. Например, вы показываете индекс риска (0–100) и несколько стандартных стратегий, формирующих портфель с max drawdown < 20 % на историческом тесте. Это сохраняет прозрачность и предотвращает слепое следование «чёрному ящику». ---

Интерфейс: от дэшбордов до диалогового ассистента

Классический дэшборд: фильтры, чарты, алерты

Подход «аналитика как дэшборд» остаётся актуален. Он хорош, когда пользователю нужно много метрик одновременно: heatmap ликвидности, распределение держателей, потоки между биржами. Такой UI строится вокруг панелей и фильтров. Важно продумать стандартизированные метрики: если у вас 10 разных определений «активного адреса», платформа быстро теряет доверие. Хорошая практика — сделать поповер с формулой и источником данных для каждой ключевой метрики.

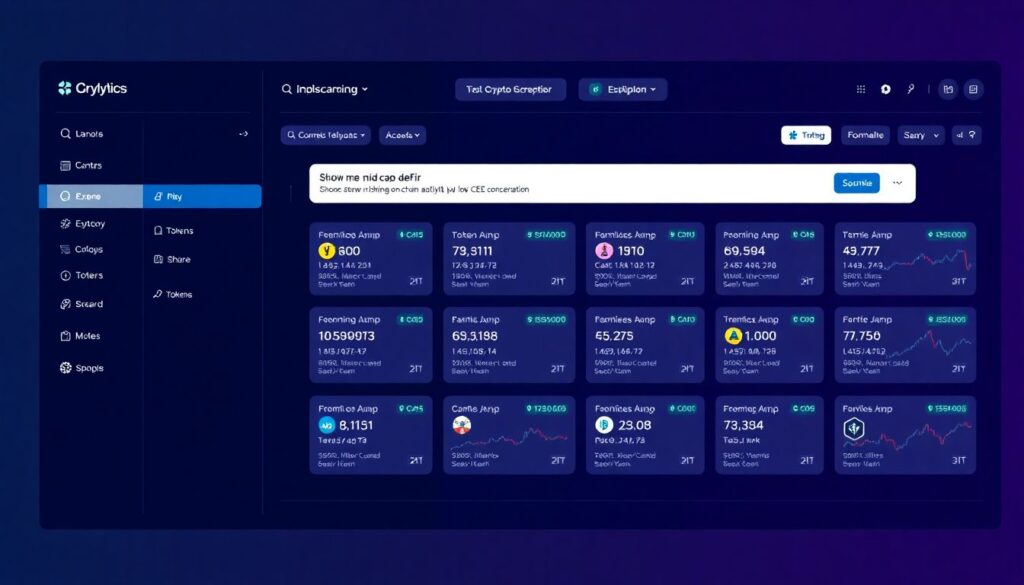

Диалоговый ассистент: LLM поверх аналитического ядра

Второй подход — сделать диалоговый слой, где пользователь пишет «Show me mid-cap DeFi tokens with rising on-chain activity but low CEX concentration» и получает curated список с пояснениями. Это ощущается как best AI tools for crypto analysis, хотя под капотом видно классический движок фильтров и скорингов. Ассистент не должен генерировать цифры из воздуха: он должен только оркестрировать запросы к вашему аналитическому API и потом форматировать результат в человекочитаемую форму с цитированием источников.

—

Оркестрация AI: монолитная модель vs модульная архитектура

Одна «универсальная» модель: соблазн и ловушка

В начале путь многих команд — это одна жирная модель, которая должна и классифицировать риски, и генерировать тексты, и подсчитывать аномалии. Поддерживать такой монолит сложно: любая донастройка повышает риск деградации других задач. В крипте, где данные нестабильны и регимы рынка резко меняются, это особенно болезненно. Ретрейны модели могут занимать часы и стоить сотни долларов GPU‑времени, а вы всё равно не понимаете, почему изменилась логика некоторых сигналов.

Модульный AI-оркестратор: набор специализированных агентов

Более устойчивый подход — модульная архитектура: несколько специализированных моделей (или даже правил), объединённых лёгким оркестратором. К примеру:

– Модуль A — скоринг ликвидности и глубины рынка

– Модуль B — риск-профиль держателей и концентрация

– Модуль C — новостной и соцмедиа sentiment

– Модуль D — LLM‑модуль для объяснений и диалога

Оркестратор получает запрос пользователя или события, прокидывает их в нужные модули и агрегирует результаты. Это напоминает AI crypto market intelligence platform с набором «микросервисов интеллекта», которые можно независимо обновлять и тестировать.

—

Практическая реализация: от прототипа к продакшену

Этап 1: быстрый прототип с внешними данными

На старте разумно опереться на готовую инфраструктуру. Для прототипа AI-driven crypto research можно:

– Взять market data API (CoinGecko, Kaiko, Binance) для котировок и объёмов

– Использовать on-chain провайдера вроде Covalent или Alchemy для базовых метрик

– Подключить новостной агрегатор (CryptoPanic, RSS фиды) и Twitter/X API

– Развернуть LLM (через API или локально) и векторное хранилище (Pinecone, Qdrant)

За 4–8 недель можно собрать работающий MVP, который ищет аномалии по объёму и активным адресам, парсит новости и строит короткие резюме по токенам.

Этап 2: собственный data lake и отказ от хрупких зависимостей

Дальше команде нужно уменьшать зависимость от сторонних поставщиков данных. Это значит: собственные ноды для ключевых сетей или надёжный managed‑провайдер, свой data lake, централизованный слой метаданных и версионирования схем. На этом этапе имеет смысл внедрить ML‑ops: отслеживать метрики моделей, деградацию качества, дрейф фич. Это превращает прототип в устойчивое automated crypto research software, а не просто «обёртку над чужими API», которую можно сломать одним изменением тарифа.

—

Безопасность и комплаенс: неудобная, но важная часть дизайна

Data lineage, объяснимость и аудит сигналов

Если продукт хоть как‑то влияет на принятие инвестиционных решений, вам нужен чёткий data lineage: откуда взялись данные, какие трансформации к ним применялись, какие модели на них смотрели. Для критичных сигналов полезно хранить не только результат, но и контекст: версию модели, набор фич, baseline. Это не только помогает при регуляторных вопросах, но и ускоряет отладку, когда клиенты спрашивают, почему тот или иной токен оказался в «чёрном списке» в конкретный день.

Риски персональных данных и API‑ключей

Если вы идёте в сторону AI-driven cryptocurrency trading platform, то неминуемо работаете с API‑ключами бирж и, возможно, с персональными данными клиентов. Минимальный набор практик: hardware security modules или как минимум KMS‑решения облака, строгое разделение ролей, шифрование в покое и в транзите, регулярные security review кода. Важно объяснять пользователю, какие данные используются для обучения: их торговая история не должна утекать в общую модель без явного согласия и анонимизации.

—

Вывод: как выбрать подход для вашей AI crypto research platform

Разрабатывая AI crypto research platform, полезно честно ответить себе на три вопроса: кто ваша основная аудитория (квантовые фонды, дискоуд‑трейдеры, DAO‑аналитики), какой горизонт решений (дни, недели, месяцы) и какую долю ответственности вы готовы взять за результат. Если пользователи — фонды, то на первом месте будут качество данных и объяснимость моделей; если ритейл — удобный интерфейс и диалоговый ассистент. В обоих случаях выигрывают те команды, которые комбинируют строгий data-first фундамент и гибкий модульный AI‑слой, а не пытаются всё решить одной универсальной моделью.