Why data versioning in crypto research is a big deal

In crypto research всё меняется быстрее, чем вы успеваете нажать “run”. Цены, объёмы, мем-токены, новые L2 — любая ошибка в данных превращает красивую модель в дорогую иллюзию. Поэтому вопрос “how to manage data versioning in crypto research projects” — не про бюрократию, а про доверие к результатам. Если вы не можете точно сказать, каким именно датасетом обучалась модель или на какой выборке строился отчёт для инвесторов, вся работа превращается в набор догадок, а не в воспроизводимое исследование.

Чем crypto-данные хуже обычных

В отличие от финансовой отчётности компаний, блокчейн течёт непрерывным потоком. Вы скачали данные по DeFi-пулу утром, а вечером ликвидность уже другая. Плюс перерасчёт исторических данных: дропы, миграции контрактов, делистинги. Ошибка в одном дне способна исказить метрики стратегии. Управление версиями здесь — способ зафиксировать “срез реальности” на конкретный момент. Так вы можете честно сравнивать модели, воспроизводить бэктесты и не спорить, “чей CSV правильный”.

Подход 1: Папки, файлики и хаос под контролем

Самый простой путь — ручное версионирование: папки вида `dataset_v1_final_final2`, Excel, локальные бэкапы. На раннем этапе это кажется удобным: всё перед глазами, никакой настройки. Но как только в проекте появляется второй исследователь, начинается путаница: разные timezone, фильтры, обработка пропусков. Этот подход быстро ломается при работе с крупными crypto market data historical datasets и долгими экспериментами. Он годится только для одиночных пилотов и быстрых проверок гипотез, но не для серьёзной исследовательской инфраструктуры.

Подход 2: Git и классическое version control software

Следующий уровень — использовать Git как version control software for data science teams. Код, ноутбуки, конфиги пайплайнов хранятся в репозитории; к данным добавляют хэши, небольшие сэмплы или интегрируют DVC/LakeFS. Плюсы: прозрачная история изменений, ветки для экспериментов, ревью коллег. Минусы: Git плохо переносит по‑настоящему тяжёлые датасеты, а без дисциплины в командных коммитах репозиторий зарастает “мусором”. Этот подход особенно силён, когда объём данных ещё умеренный, а вы хотите жёстко связать конкретную версию кода и точный набор признаков.

Подход 3: Специализированная crypto data management platform

Когда данных становится слишком много, на сцену выходит специализированная crypto data management platform. Такие решения берут на себя сбор блокчейн-данных, нормализацию, хранение “слоёв” изменений и метаданные: от источника до параметров очистки. Исследователь уже работает не с сырым JSON из ноды, а с аккуратно версионированными витринами. Плюсы: меньше ручной рутины и меньше шансов случайно сломать пайплайн. Минусы: стоимость и необходимость адаптироваться под философию платформы. Для лабораторий и фондов с долгим горизонтом исследований это часто оказывается более выгодным, чем вечный зоопарк скриптов и cron’ов.

Подход 4: Облачные решения для совместной работы

cloud data versioning solutions for research projects пытаются совместить масштабируемое хранилище и удобный контроль версий. Это могут быть дата-лейки с версионированием партиций, объектные хранилища с “версиями” объектов или специализированные SaaS над ними. Преимущество — простое масштабирование под терабайты данных и доступ из любой точки мира. Недостаток — завязка на провайдера и необходимость продумывать структуру данных сразу, чтобы не утонуть в ведёрках и префиксах. Такой путь хорошо подходит распределённым командам и коллаборациям между университетами, фондами и стартапами.

Как сравнить подходы здраво, а не “по вкусу”

Если отбросить фанатизм в стиле “Git решает всё” или “кто не в облаке, тот в прошлом”, выбор можно свести к нескольким критериям: масштаб данных, размер команды, регуляторные требования и бюджет.

– Локальные файлы: максимум свободы, минимум контроля; подходят только для ранних экспериментов.

– Git + надстройки: золотая середина для малых и средних команд.

– Платформы и облако: чуть больше входного порога, но зато порядок и воспроизводимость на долгой дистанции.

Вдохновляющие примеры и живые кейсы

Хороший ориентир — проекты, которые уже выжали максимум из данных. Например, команды, исследующие MEV и арбитраж, держат отдельные версии слоёв данных: сырые блоки, нормализованные транзакции, агрегированные фичи для моделей. Другие команды строят сложные метрики DeFi-риска, сочетая blockchain research data analytics tools и собственные пайплайны: каждый перерасчёт показателей фиксируется как новая версия витрины. Когда через год им нужно перепроверить стратегию, они просто берут ту же версию датасета и восстанавливают эксперимент до строки.

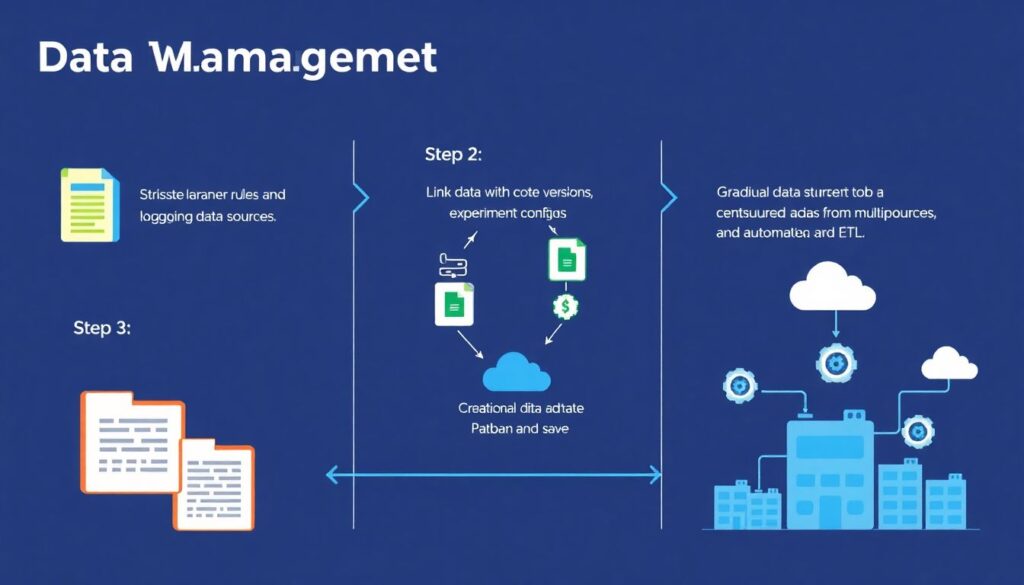

Практические шаги к зрелому версиированию

Чтобы не утонуть в теории, полезно разбить внедрение на небольшие шаги:

– Сначала введите строгие правила именования датасетов и логирование источников.

– Затем увяжите версии данных с версиями кода и конфигов экспериментов.

– Постепенно переходите на централизованное хранилище и автоматизируйте ETL.

Так вы двигаетесь от хаоса к системе без болезненных “больших миграций”. Важно, чтобы каждый новый шаг улучшал воспроизводимость: возможность честно ответить, какие именно данные стояли за каждым графиком или метрикой.

Как развиваться и где учиться дальше

Освоение грамотного управления версиями данных — это навык, который напрямую повышает вашу ценность как исследователя. Изучайте практики data engineering, читайте блоги крупных криптофондов и смотрите, как они описывают свои пайплайны. Много идей можно подсмотреть у команд, работающих с классическими финансовыми рынками: их подход к аудируемости отчётов отлично переносится на крипто. Комплексная экосистема формируется на стыке инструментов, процессов и общей культуры “никаких магических датасетов, только прозрачная история изменений”.

Ресурсы для системного погружения

Чтобы продвинуться дальше, можно собрать свой небольшой учебный стек:

– Документация по Git и расширениям для данных (DVC, LakeFS и аналоги).

– Курсы по data engineering и управлению хранилищами в облаках.

– Блоги и документация поставщиков blockchain research data analytics tools.

– Кейсы платформ, поставляющих crypto market data historical datasets.

Комбинируя эти источники, вы шаг за шагом строите собственную архитектуру, а не просто копируете чужие скрипты, которые никто не может повторить через полгода.